Intro

Traning

Function

使用 model: y=b+wx1

其中,w 表示 weight,b 表示 bias

Loss function

表示: L(b,w)

Optimization

一般性方法: 梯度下降法(gradient descent)

- 选择起始点 w0

- 计算梯度 η∂w∂L∣w=w0 (η 表示学习率 learning rate)

- 更新 w: w1←w0−η∂w∂L∣w=w0

- b 作同样操作使 L 最小

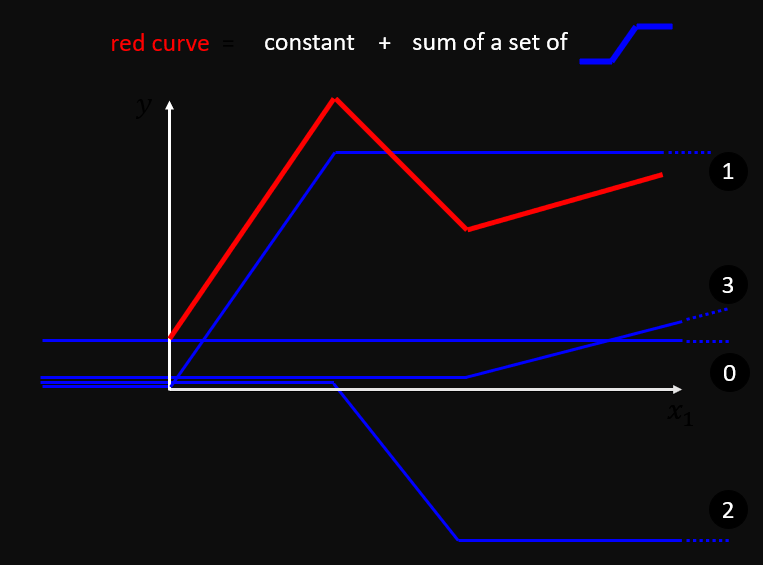

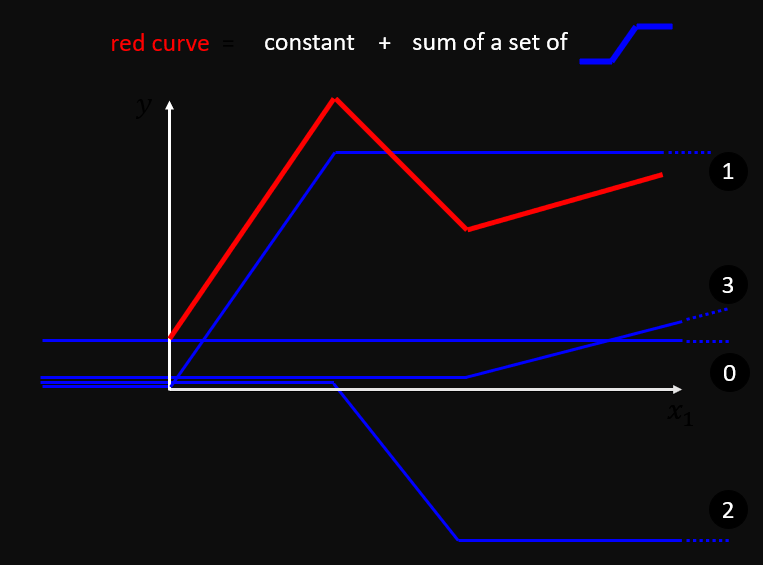

More sophisticated models

多个 model 叠加

线性叠加

使用多个线性 model 叠加即可得到更为复杂的函数拟合曲线

Sigmoid func

y=c1+e−(b+wx1)1=csigmoid(b+wx1)

使用 sigmoid 方程代替线性叠加可以得到所有的函数拟合,最终得到

y=b+i∑cisigmoid(bi+j∑wijxj)

即:

y=b+cTσ(b+Wx)

j: no. of features

i: no. of sigmoid

ReLu func

y=max{0,x}

Loss

L=N1n∑en

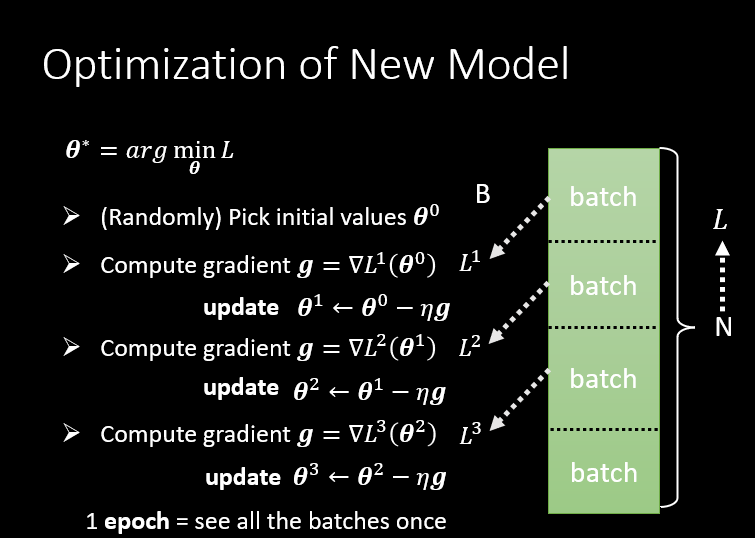

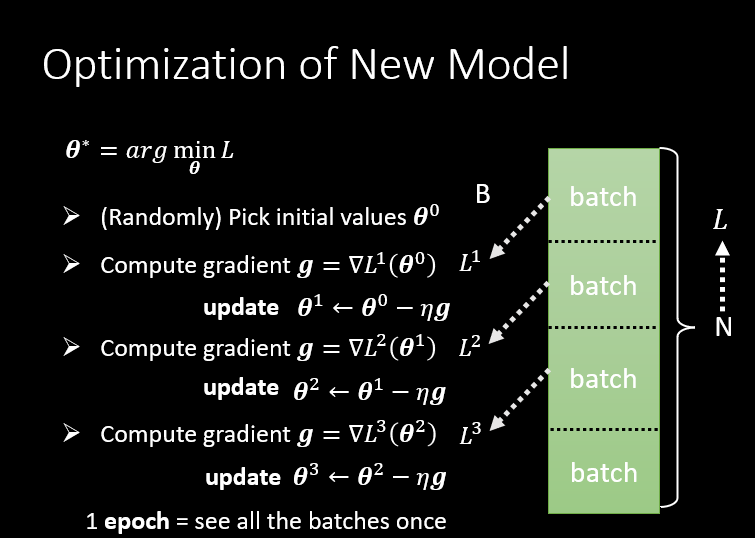

Optimization

θ∗=argminθL

梯度矩阵

g=∇L(θ0)

θ1←θ0−ηg

在实际训练中,通常使用 batch 将原始数据集分解成不同的 batch 单独计算。